セキュリティへの応用が進むAI。成果が上がる一方で、その限界も見えてきた。

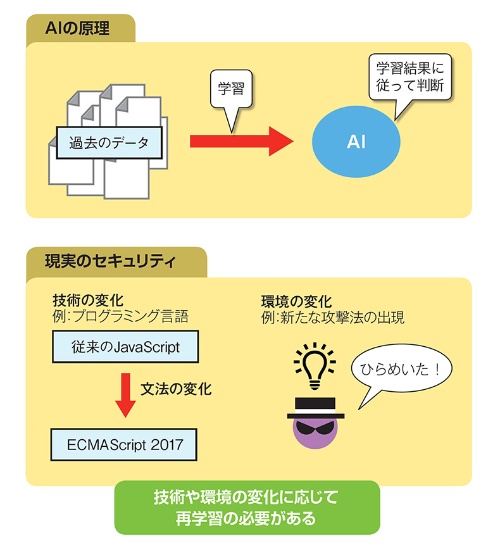

一般にAIでは、大量のデータを使ってあらかじめ学習を行う。そうしたデータはいわば過去のデータだ。つまり、AIは過去の事例に似た事例は探し出してくれるが、全く新しい事例は検出できない。

また、攻撃者が全く新しい攻撃手法を編み出した場合、AIは過去の攻撃パターンしか知らないため検出できない。そうした新しい攻撃を検出できるようにするには、学習し直す必要がある。

このようにAIは技術や環境の変化に弱いため、AIだけで完璧なセキュリティを実現するのは難しい。

AIの動作を説明できない

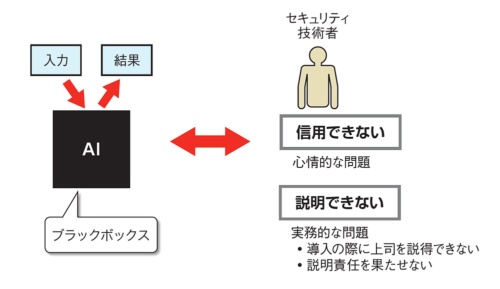

また「AIは人間が動作を理解できないブラックボックスになりやすい」という問題もある。AIが内部でどのような理由で判断を行っているかは人間には理解できないためだ。セキュリティ技術者の中には「まだAIを信用しきれない」という意見も根強い。

さらに問題なのは、「人間がAIの判断基準を説明できない」という点だ。例えば、AIを利用した製品を導入しようとしたとき、上司に「その製品が優れている理由」を説明するのが難しい。検出率の高さといった具体的なメリットを挙げることはできても、どのような処理でそのメリットを実現しているかを説明できないからだ。

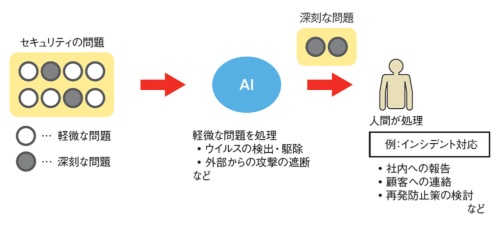

現時点では、AIはスクリーニングに使うのがよいだろう。インシデント対応などは人間にしかできない。まず、AIで軽微な問題を処理し、AIでは対応できない問題を人間が処理するのが現実的だといえる。