脳の情報でコンピュータを動かす、話者の意図をくんで翻訳する――ATRや情報通信研究機構(NICT)などが主導して研究を進めている、25年後のシステムを形作る先端技術の最新動向を追った。ほぼ1年前に日経コンピュータが25年先の情報システムがどうなるかを見据えた特集を企画した。本日もこの特集を公開する。当時指摘した内容は今も変わっていない。

思考

人間の「思い」で操作

人に優しいシステムを実現するに当たり、まず改善する必要があるのはユーザー・インタフェースだ。特に身体に障害を持つ人や老人にとって、使い勝手は非常に重要になる。現在のキーボードやマウスは、決して使いやすいものではない。

ATRの脳情報研究所は、その解決策の一つとして、脳の活動状態をコンピュータへの入力情報として利用する「脳インタフェース」の研究を進めている。「人間が考えるだけでコンピュータを操作できる。そんな時代が、着々と近付きつつある」。川人所長は、こう強調する。

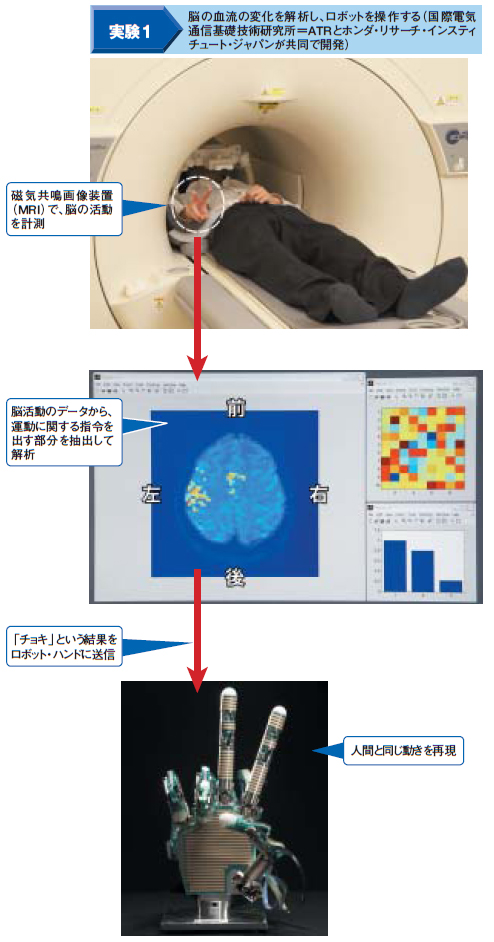

脳で「じゃんけん」の情報を伝える

川人所長が中心になり研究を進めているのは、「ブレイン・ネットワーク・インタフェース(BNI)」と呼ぶ脳インタフェースである。磁場と電波を使って人間の体内の様子をコンピュータで映像化する「磁気共鳴画像装置(MRI)」や、脳で発生する磁場の変化を計測する「脳磁計(MEG)」といった装置を使って、脳に刺激が与えられたときに、脳がどのように活動するかを計測する。そのデータから、「脳がどのような刺激を受けたか」を把握する、という流れを採る。

現状では、人間の複雑な思考パターンを扱うことはできていないが、「じゃんけん」の三つのパターンを脳からコンピュータに直接、伝える実験を成功させている。ATR脳情報研究所がホンダの先端技術に関する研究機関であるホンダ・リサーチ・インスティチュート・ジャパンと共同で実施し、2006年6月に発表した(図4左)。

この実験では、MRIに入った人間が、「グー」「チョキ」「パー」のいずれかの手の形を作る。こうした人間の動作によって、脳における血流が変化することを利用する。MRIで血流の変化を計測し、運動を指令する脳活動のデータを抽出して、どのような手の形を作ったかを解析。その結果を、ロボット・ハンドで再現するようにした。脳の外側から情報を取得する

実は脳インタフェースの研究そのものは、以前から行われている。有名なのは、米ノースカロライナ州のデューク大学が2000年に実施した実験である。サルの脳に電極を埋め込み、電極を通じて得られた神経細胞の発火パターンを解析する。するとサルはマウスなどを一切操作せずに、コンピュータのカーソルを動かせるようになったという。デューク大学では、脊椎せきついを損傷した患者など、人間に対して実施した実験例もある。

ATR脳情報研究所が研究を進めているBNIでは、脳に直接電極を埋め込む形を採らず、MRIなどを利用して脳の外側から情報を得る。「脳に電極を埋め込むと、確かに正確なデータを取得できる。しかし人間なら誰しも、脳に電極を埋め込まれたくはない。そのやり方は万人向けでないと判断した」(川人所長)。

ただ、脳の外側からデータを取得する方式では、MRIのように大型で高価な装置が必要になる上に、解析時間に数秒程度を要する。装置を小型化したり、リアルタイムに脳活動のデータを解析できるようにするのが課題だ。加えてATRは、デューク大学と共同で脳活動のデータを直接取得する研究も進めている。2007年春には、サルとロボットに同じ動作をさせる実験を実施する予定である(図4下)。

|

| 図4●脳の情報を利用してコンピュータを操作する「脳インタフェース」の研究例 |

感覚

文化を超えて共有

「人に優しい」システムを目指すためには、人間が持つ感情や感覚そのものについての研究も欠かせない。中でも、次の四半世紀で進展が期待できそうなのは機械翻訳技術だ。

ATR音声言語コミュニケーション研究所とともに研究を進めるNICTの松山隆司 知識創成コミュニケーション研究センター長は、「心理学や、言葉の裏にある文化的な背景を考慮した形で翻訳の研究を開始した」と話す。実際の通訳者は、相手の言った言葉からだけでなく、話者のプロフィールや関連資料を基に、場面に応じて適切な用語を選ぶ。これを機械翻訳でも再現しようという意図だ。

人に優しいシステムを形作る技術として機械翻訳が有望なのは、「20年にわたる研究の中でも、この数年の成果は目覚ましく、翻訳精度が劇的に向上した」(中村哲 ATR音声言語コミュニケーション研究所所長)ことも大きい。

大量の“例文”を翻訳に利用

最新の翻訳システムでは、一般旅行会話文に限ると、英語能力を測る試験であるTOEICで900点の実力を持つという。1999年には最高で563点だった。ここに感覚に関する技術を加えることで、細かいニュアンスまで含めた翻訳を可能にしていく狙いだ。

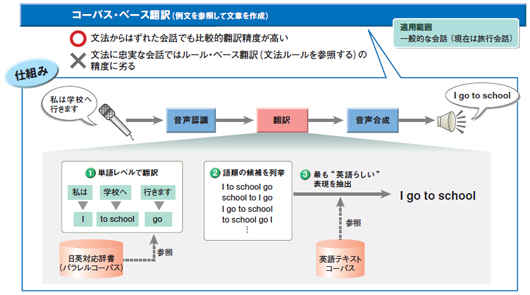

翻訳精度がここ数年で向上したのは、翻訳の仕方を変えたため。それが、2000年前後から利用している「コーパス・ベース翻訳」である。コーパスとは例文集のこと。現在のATRの翻訳システムでは、英語の場合は100万の旅行会話文をコーパスとして利用する。

従来のやり方(ルール・ベース翻訳と呼ぶ)では、翻訳の際に文法ルールを利用していた。これだと、「文法に忠実な文章は正確に訳せるが、話し言葉になると、とたんに翻訳精度が下がる」(中村所長)。

これに対し、コーパス・ベース翻訳では、「コーパスに収容した大量の例文を利用して、“最も確からしい”文章を作り出すことができる」(同)。文法からはずれた文章でも、比較的正確に訳せるのが利点だ(図5)。

コーパス方式ではまず、単語レベルで翻訳する。日英翻訳なら、「駅」を「the station」、「どこですか」を「where is」などに換える。

次に、コーパスを使って単語を最も確からしい順に並べ直す。想定される語順(図5の2)を、コーパスに収めた例文と照らし合わせると、「『where is』の後に『the station』が続く確率は、その反対よりも高い」といったことが分かる。こうして、最も確率が高い順に単語を並べると、「最も英語らしい語順」だと考えられる。この仕組みなら、文法からはずれた文章を入力しても、「英語らしい文章」を生成できるわけだ。ATRはコーパス方式を従来のルール方式と併用している。

|

| 図5●コーパス・ベース翻訳技術の流れ [画像のクリックで拡大表示] |

もちろん課題もある。今のコーパスでは、旅行会話以外の場面や、固有名詞が登場する状況では利用しにくい。翻訳対象を広げるには、コーパスをより充実していく必要があるという。

“臨場感”の解明に挑む

物理的に離れていても、あたかもその場所にいるかのような“臨場感”を伝える技術の研究も進んでいる。これを使うと、長時間の移動に耐えられず、海外旅行に行きたくても行けない人でも、その雰囲気を味わえるようになる。それには人間が臨場感をどうとらえるかを調べる必要がある。

ATR認知情報科学研究所はNICTと共同で、2006年4月に臨場感の研究に着手した。井ノ上直己所長は、「臨場感を構成する要素を特定したい」と話す。例えば、テレビ会議システムなどを使って遠隔地にいる人と会話するときに、「相手と目線が合う」、「相手が座っているイスがきしむ」といったことを再現できるようにしていく。旅行先の臨場感を伝えるためには、「日差しやにおいなどを伝える必要もあるだろう」(同)という。

現在は、正面、左右、床の4面にコンピュータ・グラフィックス画像を投影した部屋に入った人が、その場所にいる感覚になるかを調べたり、触覚を再現するためにはどのような装置が必要か、などを研究している。

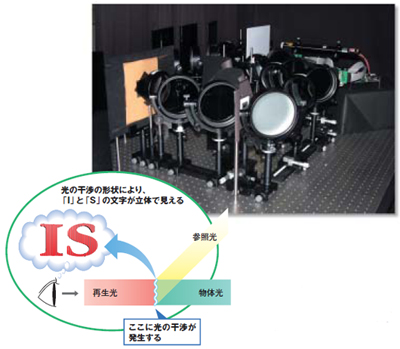

NICTは、ホログラフィと呼ぶ立体映像の研究にも取り組んでいる。ホログラフィを利用すると、特別な眼鏡を使わずに、立体的に映像を見ることが可能になる。複数のレーザー光線を照射したときにできる光の干渉模様が物体のように見える原理を利用する(図6)。

|

| 図6●ホログラフィの映写機とその原理 写真左の黒い板の向こう側から立体映像が見える |

紙幣やクレジットカードについているようなホログラフィは、干渉模様を写真に焼き付けて、写真の像が浮き上がっているように見せている。現在、試みているのは、同じ原理を使い、何もない空間に立体の像を映写する実験である。「すでに利用されている、眼鏡を使った立体映像の次の次の技術。実用化は30年以上先になるだろう」(NICTの榎並和雅ユニバーサルメディア研究センター長)。

NICTはこの方式で、赤1色で描いた文字を立体映像として表示させることに成功している。ただし、立体視できるのは、見る人がホログラフィから3度の角度の範囲に立った場合。そこからはずれると何も見えなくなる。「20年後をメドに、視野角を20度まで広げていきたい」(榎並センター長)。