|

データセンターなどで準備されている19インチ・ラックは,全高1800mm~2000mmのモデルが一般的だ。ユニット・サイズで言うと35Uから45Uまでが収納可能である。1Uサーバーの高さは44.45mmなので40台まではマウントできるが,ラックのユニット・サイズのギリギリにマウントすると,メンテナンスが困難になるため,スペースの余裕を考慮して30~35台を搭載するのが一般的だろう。

しかし,消費電力を考慮しないでこの数のサーバーを積み上げていくと,後で面倒なことが起こる。システムの寿命が短くなったり,運用性,メンテナンス性の低下したりするのである。

現在,流通している2GHz前後のデュアルコア・チップを搭載した1Uサーバーの最大消費電力量は約200W~220W程度。実効値を70%として電圧100Vで稼働させるとすると1台当たり3A(200~220W/70V)の電力量が必要となる。これを1ラックに30台搭載すれば,100V/90Aの電源が必要になるわけである。

アプリケーション・プログラマやサーバー・エンジニアにとっては,どこにも不自然さを感じないかもしれない。しかし,ファシリティ的な視点でいうと,これはあまりにも非常識,かつ無謀な設備設計である。どのように非常識,無謀なのかをデータセンターを例に説明しよう。

ラック内の温度が上昇

一般的なデータセンターの電源サーキットは,1ラックあたり20Aもしくは30Aで設計されている。1ラックに40Aの電力が必要なら,20Aの電源回路を2系統提供するという手法を取る。このように,理屈上は通常のデータセンターでも,20Aの倍数か30Aの倍数で電源が利用できることになり,30Aサーキットを2系統入れれば60Aのラックが出来上がる。さらに,30Aサーキットを3系統提供すると90Aのラックは作れてしまうのである。

ここに落とし穴がある。90Aの電源を使ってラック内のシステムを稼働させるとどうなるか?サーバー内に冷却できないほどの熱がたまってしまうのである。ラックに特別な冷却システムでも導入しない限り,90Aの電力でシステムを稼働し続けると,ラック内の温度は上昇し,サーバー自体の内部温度は最大稼働許容温度を超え,誤動作やシステム・ダウンを引き起こす。部品の劣化などによる機器破壊などに及ぶこともある。

データセンター側でも,その気になれば1ラックあたり90Aという電力供給を準備することは可能である。しかし,冷却がそれに追いつかない。少なくとも,現在,標準的な19インチラックを提供するデータセンターで,1ラック6000W(60A×100V)以上の発熱量を確実に冷却する手段はない。

仮に,ラック自体が冷却システムを備えていたとしても,廃熱風は専用のパイプなどで外気に排出されるのではなく,センター内の空気中に排出される。データセンター・ルーム内全体の平均温度を上げ,周囲のラックに影響を与えてしまう。つまり,そのラックの問題では無くなるのである。

冷却効果を上げるため,ラックごとに設置可能な空調設備をどんどん投入していけば,何とか稼働許容範囲内にラックの温度を維持することができるかもしれない。しかしそれでは,省スペースによるコスト削減を目的としたラック・マウンティングであったにもかかわらず,逆にラック単価コストが上昇してしまい,何のためのシステム設計だったのか分からなくなる。

さらに,何らかの理由でデータセンターの変更を強いられ,システムを移設しようとしても,標準的なデータセンターでは1ラック60Aのホスティングは行われていない。行き先が見つからずに右往左往する羽目になる。移転先に無理に追加電力,追加冷却用空調システムを導入させると,そこにかかる追加コストは計り知れない。

カタログ値は実測値と必ずしも一致しない

このような過剰電源の要求は,実際にしばしば起きている。なぜか?それはシステム設計者が現場を見ず,カタログ値だけで設計してしまうからである。サーバーが実際にどれくらいの電力を消費するかを知った上で設計すれば,今,90Aが必要だと思われているシステムでも,60A以内の電源で済ませられるものはいくつもある。カタログ上の消費電力(W)は,安全係数が掛けられているため,実際の消費電力よりもかなり高めに設定されている。

筆者が過去に実測した経験上,カタログ上の消費電力量170Wと示されているIntel PentiumIII 800MHzのCPUを搭載したサーバーは100Vで1.7Aの電流を消費するはずだが,実測消費電流は1A前後だった。Intel Xeonクアッドコア 1.86GHzのCPUを搭載したサーバーのカタログ・スペックは700Wと表示されており100Vで7Aを消費するはずだが,100V稼働による実測消費電流は2A程度だった。この値はCPUの稼働率に依存せず,常にほぼ一定の値を取る。メモリー容量,ディスク・ドライブ数などによって若干の差異は生じるであろうが,カタログで表示される値ほどではない。

カタログ情報だけに頼り,実測値を知らずしてシステム要件を設定することは過剰投資を引き起こす。

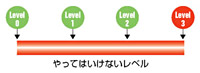

目安としては1ラック20Aを2系統,もしくは20Aと30Aの2系統程度に収め,総消費電流を60A未満とするのが望ましい。多少それを超えてもシステムのファシリティ的に不可能は無いとは思うが,長期的な設備投資,運用コストを考えて設計することが重要である。

重要なのはカタログの消費電力をうのみにせず,実稼働状態での消費電力を把握し,ごく標準的なデータセンターで提供できる電源容量の範囲内でシステム設計を行なうことである。それが真のシステム設計者が行うべき設計手法である。実際にオペレーションを行なう運用者やエンジニアの経験を十分参考にしてラックマウント・レイアウトや構成,電源容量,ラックの位置,データセンター・ロケーションなどを決定すべきである。机上の論理による積み重ねだけでシステムは安定稼働しないものだ。

|